Son visage n’a ni yeux, ni nez, ni bouche. Seulement un écran, un bandeau numérique lui voilant la face à l’horizontale ; presque une allusion grinçante à notre époque surconnectée. A l’allumage, il prévient “fonctionner à l’aide d’OpenAI”, le créateur de ChatGPT. Cela va vite se voir. Le robot “One” de l’entreprise Figure faisait l’objet d’une nouvelle démonstration à la mi-mars. “Salut Figure One, qu’est-ce que tu vois maintenant ?”, lui demande un ingénieur. “Je vois une pomme rouge sur une assiette au centre de la table, un égouttoir…”. Bien planté sur ses deux jambes, le robot décrit parfaitement l’espace devant lui, d’une voix lente et métallique, comme sortie de ses entrailles. “Est-ce que je peux avoir quelque chose à manger ?”, rétorque l’ingénieur. “Bien sûr”. “One” déploie alors ses longs bras et attrape la pomme de ses mains. “Peux-tu m’expliquer pourquoi tu as fait ça ?”, questionne l’humain, en lui tendant au passage une caisse et lui ordonnant d’y jeter des déchets. Le robot exécute simultanément avec aisance la tâche cognitive – expliquer son action – et la tâche physique – débarrasser.

Figure est la nouvelle start-up en vogue de la robotique. La société américaine vient de lever 675 millions de dollars auprès de prestigieux investisseurs : OpenAI, bien sûr, ainsi que Microsoft ou encore Amazon. Les grands noms de la “Big Tech”. Elle incarne actuellement les fulgurants progrès de la discipline. Comme la démonstration l’a prouvé, l’avènement de l’IA générative y est pour quelque chose. La technologie bluffe actuellement le monde entier. Pour la première fois, en lui parlant en langage naturel, une machine répond à une question ou un ordre sur lequel elle n’a pas été entraînée spécifiquement. Alors qu’on pensait ces IA incapables de briller dans des tâches manuelles, l’évolution technologique prouve déjà le contraire.

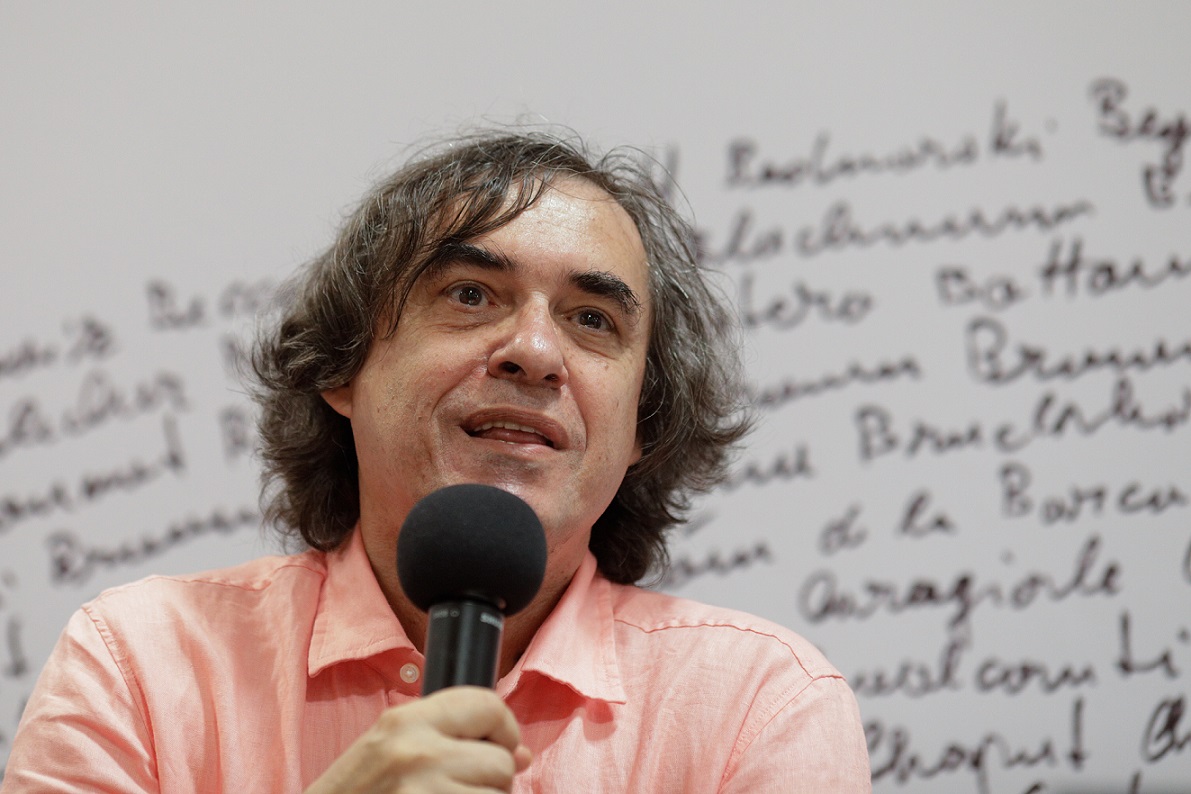

Dans le secteur de la tech, une même idée se répand : les robots humanoïdes dotés de bras et de jambes, comme ceux de Figure One, seraient un bon moyen de tirer parti de ce potentiel. Ils pourraient aller chercher des objets, assister dans les entrepôts ou les hôpitaux, patrouiller sur les plateformes pétrolières ou les égouts dans lesquels on espère toujours envoyer moins de mortels. “Décliner beaucoup plus d’actions, être plus polyvalent”, complète Matthieu Cord, professeur de robotique à la Sorbonne. Pourquoi pas même, un jour, se rendre utile dans nos maisons. “L’IA générative va permettre aux robots d’évoluer avec les humains”, insistait dès l’été dernier Vincent Vanhoucke, le patron de Google DeepMind, dans un entretien à L’Express. Jensen Huang, iconique patron du concepteur de processeurs informatiques Nvidia, et lui aussi investisseur de Figure, a récemment admis lors d’un événement que “le moment ChatGPT pour les robots est peut-être au coin de la rue”.

Dextérité, vision…

L’idée de donner un cerveau à des robots ressemblant à des humains ne date pas d’aujourd’hui : la science-fiction a été la première à l’imaginer, de Terminator à C3PO. Les essais jusqu’à présent n’avaient pas été concluants. Peu bavards, souvent pas très maniables, les robots ont surtout essaimé dans l’industrie sous la forme de bras articulés ou de convoyeurs de marchandises. Comme des outils, aux règles très codifiées. Les LLM – le socle des applications génératives – ont changé les règles du jeu. Ces derniers officient comme des bases de données géantes pour les robots. De quoi leur permettre de “manipuler des objets qu’ils n’ont jamais vus, de se déplacer dans des environnements divers jamais visités”, nous expliquait également Vincent Vanhoucke. Les LLM, maîtrisant à merveille le langage, servent aussi à la décomposition et à la planification des tâches, ainsi qu’à leur traduction en mouvement.

La robotique surfe sur d’autres progrès technologiques. “La qualité de la vision : désormais, les robots voient aussi bien que les hommes”, indique Matthieu Cord. Peut-être même mieux. Le résultat, notamment, des nombreux travaux menés pour créer des véhicules autonomes capables d’identifier des piétons, des marquages de route ou des panneaux à grande vitesse. Nvidia a annoncé, cette semaine, la publication d’un nouveau modèle d’apprentissage exploitant ces qualités, baptisé Gr00t. “Aujourd’hui, ces robots évoluent vers des machines auto-apprenantes qui se nourrissent de diverses sources de données telles que les relevés de capteurs, les images de caméras, les commandes vocales/textuelles et même les démonstrations humaines”, décrypte Deepu Talla, vice-président de la section robotique chez Nvidia.

Les capacités sensorielles des machines sont un autre champ de ces travaux. Nicolas Mansard, directeur de recherche en robotique au LAAS-CNRS, et développeur de Talos, un robot humanoïde français, évoque les études actuelles sur la “peau” des robots. En réalité, un système de capteurs, disposés sur les bras, le torse, afin de jauger le poids et la matière des éléments. “Les robots en usine, tels ces bras qui assemblent des voitures, ne sentent pas les efforts qu’ils exercent”, rappelle Nicolas Mansard. Leur demander de porter des objets fragiles est donc risqué. Cela pose également problème “si l’on souhaite accomplir des tâches précises, par exemple, de la gravure ou du meulage. Il est alors nécessaire de quantifier les efforts demandés au robot”, précise le scientifique. Ceux qui ne sentent pas leur force sont, enfin, plus dangereux pour l’homme.

Des robots sportifs

Les mouvements des robots, quant à eux, se sont améliorés. Apptronik, avec son humanoïde Apollo, peut se déplacer avec 25 kilos de charge sur les bras. Phoenix, de la compagnie Sanctuary AI, sait scanner un code-barres à l’aide d’une douchette. Avec plus de dextérité encore, un Optimus de Tesla sait manipuler un œuf sans le casser. En janvier, Figure avait montré son robot se servir une tasse de café à l’aide d’une machine à capsule.

Des robots font même preuve d’une agilité phénoménale, à l’exemple des quadrupèdes développés par Boston Dynamics. “Ces appareils sont désormais très matures. Ils marchent bien sur tout type de terrain avec beaucoup d’autonomie. Ils sont capables de tomber et de se relever facilement, de s’aventurer dans la nature ou des sites qui n’ont pas été conçus pour des robots”, distingue Nicolas Mansard. Tout l’inverse des humanoïdes, qui ont parfois besoin de lourds moteurs à leurs chevilles pour soulever leurs jambes, et sont dans l’ensemble très peu stables. “L’humanoïde repose sur une base de support très petite et il en faut peu pour le faire tomber”, rappelle Serena Ivaldi, directrice de recherche à l’Inria. “D’ailleurs, Figure, dans ses vidéos, effectue des marches plutôt classiques, dont on sait qu’elles fonctionnent dans certaines conditions.”

C’est ce qui rend les robots humanoïdes encore difficiles à vendre. “Le voir comme un produit me semble présomptueux”, estime Nicolas Mansard. L’objet est encore coûteux – Tesla avait évoqué pour son Optimus un coût d’environ 20 000 dollars. “Les industriels se demanderont si le coût est justifié par l’application”, souligne Serena Ivaldi. Il faut aussi garder l’esprit que les robots ont une batterie, qui tient généralement une à quatre heures. Et qu’en cas de panne ou de casse, ce qui arrive fréquemment en cas de chute, il faut les réparer.

Il reste ainsi une marge de progression aux robots humanoïdes, notamment dans la mécatronique, le mouvement, mais également dans l’intelligence. Avec les LLM, le taux de réussite des expérimentations des ingénieurs de chez Google DeepMind oscillait entre moins de 50 % – le raisonnement – et plus de 75 % – la reconnaissance de symboles. La fiabilité n’est pas encore au rendez-vous. Le même mystère entoure Figure. “Tant qu’il n’y a pas d’article scientifique, on ne peut pas vraiment savoir”, résume Serena Ivaldi, qui rappelle que les vidéos publiées par les entreprises comme Figure ou DeepMind, ne sont que des morceaux choisis, parmi des heures et des heures de test. Elles sont faites pour impressionner. Avouons-le, c’est réussi.